Tiefe probabilistische Modelle für die terrestrische Radarinterferometrie

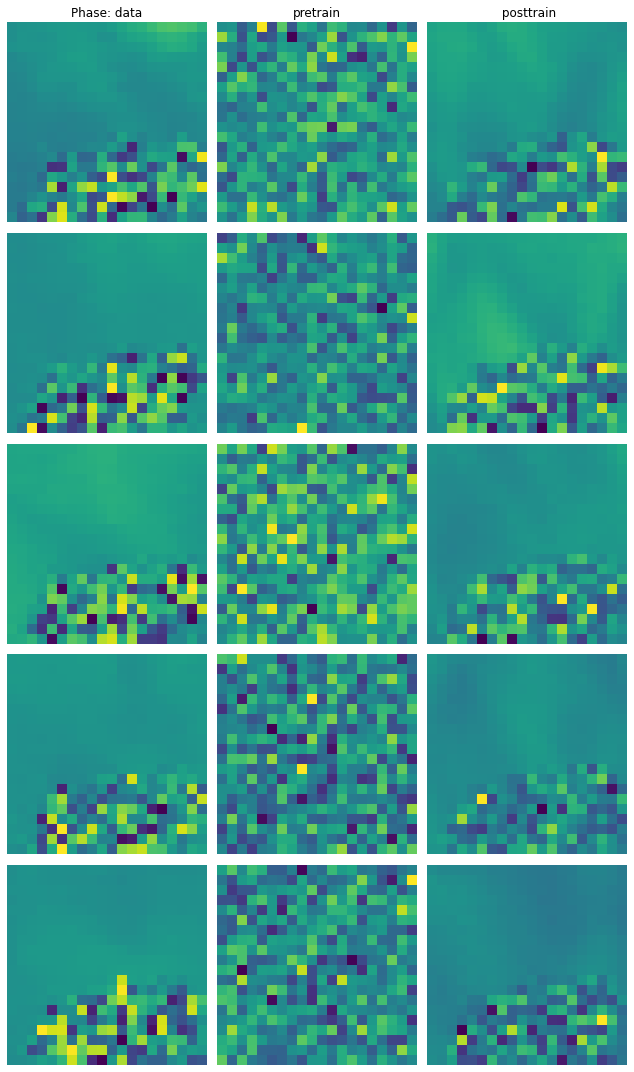

Terrestrische Radarinterferometrie (TRI) hat sich als wertvolles Instrument zur Überwachung von Oberflächenverformungen etabliert. Der Einfluss von Faktoren wie Atmosphäre, Oberflächenbeschaffenheit, geometrischen Eigenschaften und Einfallswinkel auf die Erzeugung von TRI-Daten ist jedoch noch nicht vollständig verstanden. Vor diesem Hintergrund zielt diese Studie darauf ab, ein flexibles stochastisches Modell zu entwickeln, das anhand von realen TRI-Daten trainiert werden kann. Wir modellieren TRI-Daten als Ergebnis eines Gaußschen Prozesses (GP), bei dem die Verteilungsparameter des GP – Mittelwert und Kovarianz – nicht fest sind, sondern Funktionen von erklärenden Variablen darstellen. Diese Variablen werden durch ein künstliches neuronales Netzwerk (ANN) verarbeitet. GPs sind von Natur aus flexible Modelle, die in der Lage sind, komplexe Beziehungen zwischen Variablen durch ihre Kernel-Funktionen zu erfassen. Durch die Einspeisung der Ausgabe des ANN in den GP führen wir effektiv ein weiteres datengetrieben anpassbares Element ein; das ANN lernt die funktionalen Abbildungen, die am konsistentesten mit den beobachteten Daten sind, und diese Abbildungen determinieren nachfolgend die Verteilungsparameter des GP. Wir verwenden eine Zerlegung der Kernel-Funktionen in ein Skalarprodukt im Hilbertraum L2. Dies stellt sicher, dass die Kovarianzmatrix positiv semidefinit ist, eine entscheidende Voraussetzung für ein effektives GP-Modell. Das stochastische Modell ist in Pyro implementiert, einem auf PyTorch basierenden probabilistischen Programmier-Framework. Es ermöglicht für das maschinelle Lernen typische Trainingsverfahren, welche Backpropagation zur Optimierung der ANN-Parameter nutzen und das ANN so abstimmen, dass es Verteilungsparameter vorhersagt, die maximal konsistent mit den beobachteten TRI-Daten sind. Beim Trainingsprozess werden die Daten batchweise prozessiert und zur Berechnung stochastischer Gradienten verwendet. Das resultierende Modell erfüllt mehrere Zwecke: Es klärt grundlegende Beziehungen, wie etwa den Einfluss der Kohärenz auf das Rauschniveau, und ermöglicht Simulationen. Die Kompatibilität des Frameworks mit Markov-Chain-Monte-Carlo Methoden (MCMC) ermöglicht fortgeschrittene Analysen wie etwa die Ermittlung erforderlicher Integrationszeiten zur Erreichung vordefinierter Genauigkeitsniveaus und die Bewertung von Fehlerwahrscheinlichkeiten. Vorläufige Ergebnisse deuten darauf hin, dass die aus dem Modell generierten synthetischen Daten, den realen TRI-Daten stark ähneln. Dies unterstreicht das Potenzial der Modelles, TRI-bezogene Echtweltzusammenhänge zu repräsentieren und zu simulieren. Diese Arbeit zielt darauf ab, die Fähigkeiten von tiefen probabilistischen Modellen in der Geodatenanalyse zu demonstrieren und zeigt Möglichkeiten auf, die Bandbreite der trainierbaren Instrumentenmodelle zu erweitern.